Free Backlink dari Google Colab

|

| Ilustrasi - Cara Buat Backlink dari Google Colab |

Backlink dari google colab? mungkin beberapa pegiat web agak terasa awam dengan nama google colab. Namun berbeda jika itu anak-anak pegiat python dan jupyter notebook pada umumnya. Sebelum kita masuk ke pembahan ke cara pembuatan tautan dari google colab ini, saya akan memberikan ringkasan sedikit tentang tautan dan google colab itu sendiri.

Apa itu Backlink?

Backlink atau bahasa Indonesia kita sepemahaman saya tautan balik, sepamahaman saya lho ya, ini saya nulis tanpa liat google btw hehe. Secara bahasa singkatnya tautan balik, namun secara teknis backlink merupakan sebuah link atau tautan dari sebuah website ke website lain.

|

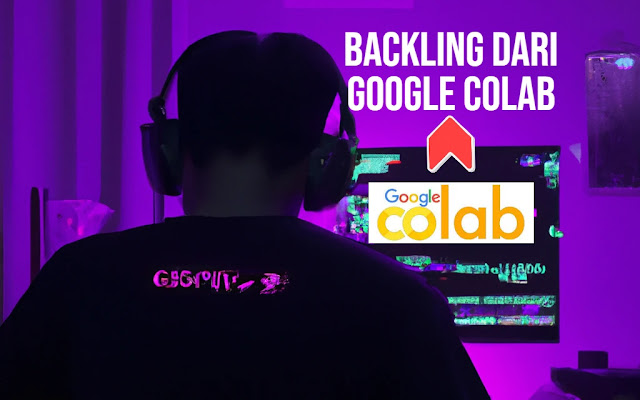

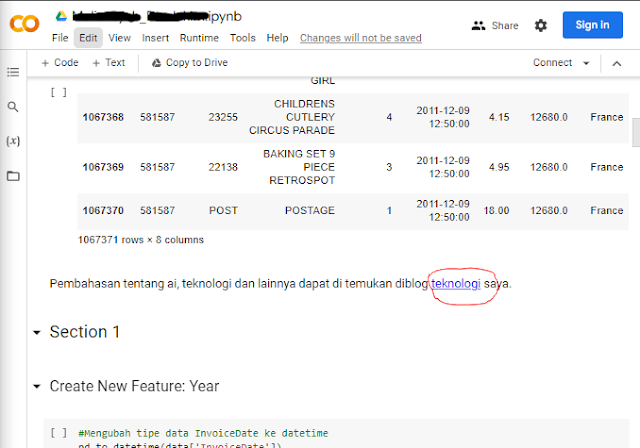

| Contoh Backlink dari Google Colab |

Seperti yang dilihat pada gambar khususnya pada kata "teknologi" yang saya lingkari merah tersebut dapat dikatakan sebuah backlink, dimana tautan tersebut mengarah ke blog saya. Mungkin itu saja ringkasan backlink yang saya sampaikan untuk sekarang. Backlink akan saya buatkan topik khusus nanti, tentu saja banyak yang bertanya apa hukumnya pakai backlink bre?, kenapa harus pakai backlink bre?, cara buat backlink gimana bre?, supaya bagus masang backlink gimana bre?, apakah ada backlink berbayar bre?. Hehe nanti akan saya bahas satu persatu.

Apa itu Google Colab?

Google Colab sepahaman saya adalah sebuah notebook (bisa dibilang salah satu editor python) yang ternyata gabungan dari 3 bahasa pemrograman, yaitu Julia, Python dan R. Sehingga dapat dikatakan bahwa sebuah jupyter notebook yang disediakan secara online (berbasis cloud) oleh google dengan akses gratis. Pada praktiknya banyak para akademisi yang sangat terbantu dengan adanya Google colab ini, termasuk saya sendiri. Bahkan skripsi saya juga menggunakan google colab. Penggunaan google colab sendiri seringkali berhubungan erat dengan data science dan machine learning bahkan deep learning. Salah satu pengaplikasian google colab yang saya tahu misalnya adalah sentimen analisis atau klasifikasi sebuah gambar.

Nah dari pengerjaan skripsi saya yang cukup menantang kemarin, saya menyadari bahwa google colab ini dapat dijadikan sebagai sarana untuk membuat tautan. Namun, tidak dipungkiri untuk membagikan ini bagai 2 mata coin, dimana bisa jadi hal yang baik dan buruk. Sisi baiknya ya pembuatan backlink yang sesuai konteks sehingga tidak menyebabkan terganggunya ekosistem dari google colab itu sendiri. Sisi buruknya ya tentu saja jadi sarana spam, alat indexing dan lain-lain yang menjadikan ekosistemnya jadi hancur.

Cara Buat Backlink dari Google Colab Gratis

Sebelum saya jelaskan cara membuat tautan dari google colab ini, sedikit disclaimer bahwa pembuatan agak susah dan ribet.

- Pertama, masuk ke sub domain colab.research.google.com, pastikan masuk akun google seperti produk layanan google lainnya.

- Selanjutkan buat notebook baru, ada dimenu file atau ngga biasanya pas awal masuk ada pop up gitu terus cari aja new notebook.

Tampilan pop up google colab - Langkah yang agak tricky senjutnya adalah memasukan code, nah ini tergantung kreativitas ya bisa buat sendiri atau tau sendirilah ya anak blogger biasanya cam mana yekan. Saya tidak anjurkan yang aneh aneh ya, tapi kalo mau usah gampang kok cari aja contoh di github atau keaggle dengan keyword data visualisation notebook atau semacamnya. terus amati tiru dan modifikasi.

- Langkah keempat kalian bisa memasukkan backlink dengan cara mengklik menu (+ text) pada pojok kiri atas, dibawah toolbar menunya. Kalian bisa menuliskan teks atau keyword kalian dan memberikan backlink pada teks tersebut.

Menambahkan teks dan tautan di google colab - Langkah terakhir jangan lupa untuk mengubah general akses dari notebooknya, nanti akan ada link yang dapat kalian index atau menunggu sendiri bakclink ke index.

Memberi akses anyone di google colab

Contoh Tautan dari Google Colab

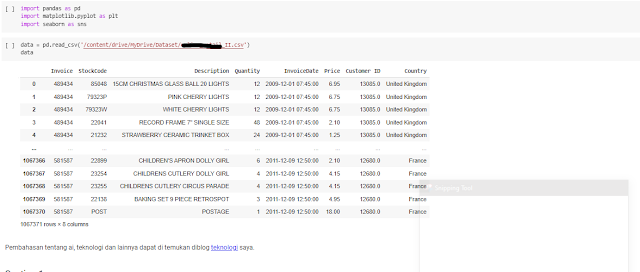

Berikut adalah contoh tautan yang saya buat di google colab dan saya selipkan antara codingan.

|

| Contoh Peletakan Backlink Google Colab |

Contoh Tautan Google Colab yang telah Terindeks

Untuk mengindeks backlink kalian dapat melakukan dengan berbagai cara, kalau kalian tidak tau cara dapat melakukan pencarian di google dengan keyword cara indeks tautan. Namun kalian juga bisa menanyakan ke saya secara pribadi dan akan saya jawab. Tinggalkan aja pesan di page contact web ini ygy.

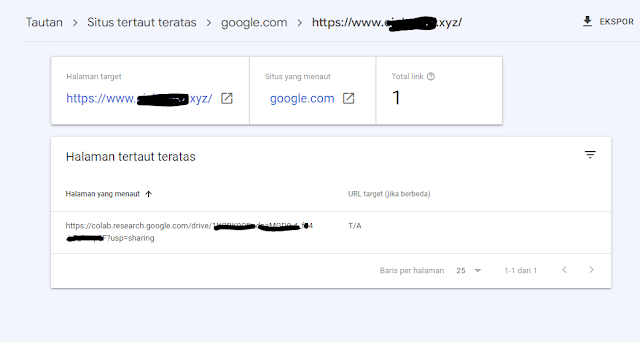

Berikut contoh tautan google colab yang terindeks

|

| Tautan google colab yang terindeks |

Tautan juga dapat ditemukan pada search atau serp google lakukan pencarian dengan "site:link" untuk melakukan pengecekan. Berikut Tautan google colab yang ada di SERP.

|

| Backlink google colab pada SERP |

FAQs

- Apakah backlinknya dofollow ?

Tidak, sepahaman saya backlink google colab ini sifatnya nofollow. - Apakah proses indeksnya lama ?

Bisa jadi, karena sepahaman saya indeks sebuah backlink sendiri cukup memakan waktu. Namun untuk kasus saya memakan waktu 1 minggu dengan bantuan metode saya sendiri.

Kesimpulan

Penggunaan backlink cukup penting pada dunia blogger, baik itu backlink dofollow ataupun nofollow. Backlink yang baik berasal dari web dengan DA PA yang tinggi dan SS yang rendah bahkan nol. Backlink dari Google colab sepamahaman saya adalah nofollow ygy, namun tak apa tak ada salahnya. Saya harap penggunaan dari tautan dari google colab ini digunakan secara bijaksana dan kembali lagi ke pribadi masing masing. Sekian artikel ini saya buat, kurang lebih mohon maaf ygy. Sejauh ini masih sedikit yang saya lihat menggunakan trick ini, semoga berguna.